Empresas líderes carregam legados que moldam mercados. Na atualidade, garantir esse protagonismo exige adotar inteligência artificial com abordagem estratégica. No Distrito, essa convergência se transforma em soluções que sustentam sua competitividade e ampliam sua capacidade de transformação.

Da definição da estratégia à implementação de tecnologia proprietária, estruturamos uma jornada completa para nossos clientes.

Alinhe negócio, tecnologia e governança em uma única estratégia.

Alinhe negócio, tecnologia e governança para capturar valor real com IA, priorize os casos de uso com maior potencial de impacto, estruture uma governança robusta com guardrails para mitigar riscos, crie um roadmap executável que conecta a visão estratégica aos resultados e prepare sua organização para escalar o uso de IA com segurança.

Leve a estratégia para toda a organização ativando nosso ecossistema, conecte-se a soluções de ponta do mercado por meio do GenAI Lab e de programas de Inovação Aberta, ative o potencial inovador de suas equipes com intraempreendedorismo e organize e gerencie seu portfólio de iniciativas com a Plataforma ÍON.

Forme executivos e times preparados para aplicar inteligência artificial.

Capacite líderes e equipes para aplicar IA de forma estratégica, identifique oportunidades de negócio e casos de uso de alto impacto, aplique ferramentas de inteligência artificial para otimizar processos do dia a dia e desenvolva uma cultura de dados e governança em toda a organização.

Prepare suas equipes técnicas para construir soluções de IA robustas, desenhe arquiteturas de aplicações de IA seguras e escaláveis, domine a integração de modelos, sistemas e frameworks de mercado e padronize boas práticas de desenvolvimento para reduzir riscos técnicos.

Implemente soluções de IA seguras, escaláveis e sob medida na sua empresa.

Desenvolva e implemente soluções de IA proprietárias e escaláveis, crie tecnologia customizada, de modelos preditivos a agentes autônomos, integre a inteligência artificial aos seus sistemas, dados e ecossistema de plataformas e garanta a performance de cada solução com monitoramento e métricas claras.

Gigante global do setor de eletrodomésticos capacitou lideranças e equipes em IA, conectando estratégia e prática. Com apoio do AI Education do Distrito, a empresa criou um portfólio de projetos, estruturou governança e consolidou uma cultura de inovação sustentável com uso responsável da IA.

Rede hospitalar implementou uma solução com multiagentes de IA para integrar sistemas, automatizar orçamentos e transformar o contato com pacientes. O resultado foi um atendimento mais ágil e personalizado, com ganhos expressivos de eficiência operacional e segurança.

Empresa integrou dados de diversas unidades para aprimorar decisões de mercado e otimizar suprimentos. Com engenharia de dados, automação de consultas e visualização estratégica, a solução melhorou a qualidade das informações e fortaleceu o poder de negociação com fornecedores.

Projetos de inteligência artificial implementados em grandes corporações.

Profissionais capacitados para aplicar inteligência artificial em áreas de negócio.

Das principais startups de IA brasileiras, residentes em nosso programa, o GenAI Lab.

Startups mapeadas gerando inteligência e oportunidades de mercado na Plataforma ÍON.

Artigos sobre inteligência artificial, inovação e transformação corporativa no Brasil e no mundo.

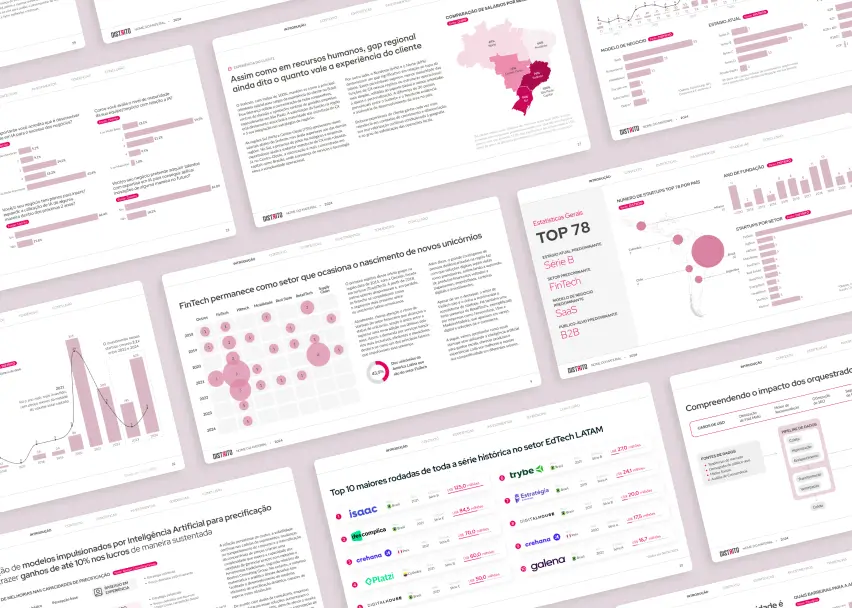

Relatórios de mercado fonte de consulta para executivos e empresas líderes.

Assine nossa newsletter e receba semanalmente as principais notícias do mercado de inteligência artificial.